GLM-5来了,依然采用 MoE 架构,总参数从 GLM-4.5 的 3550 亿翻倍至 7440 亿,激活参数从 320 亿提升到 400 亿,预训练数据也从 23T tokens 扩充到 28.5T tokens。

技术上有两个关键亮点:

1️⃣集成了 DeepSeek 的稀疏注意力技术 DSA,在保留强悍长上下文能力的同时有效降低部署成本,

2️⃣针对大模型强化学习训练效率偏低的行业痛点,智谱为 GLM-5 专门自研了一套异步强化学习框架 Slime,从底层优化训练效率。

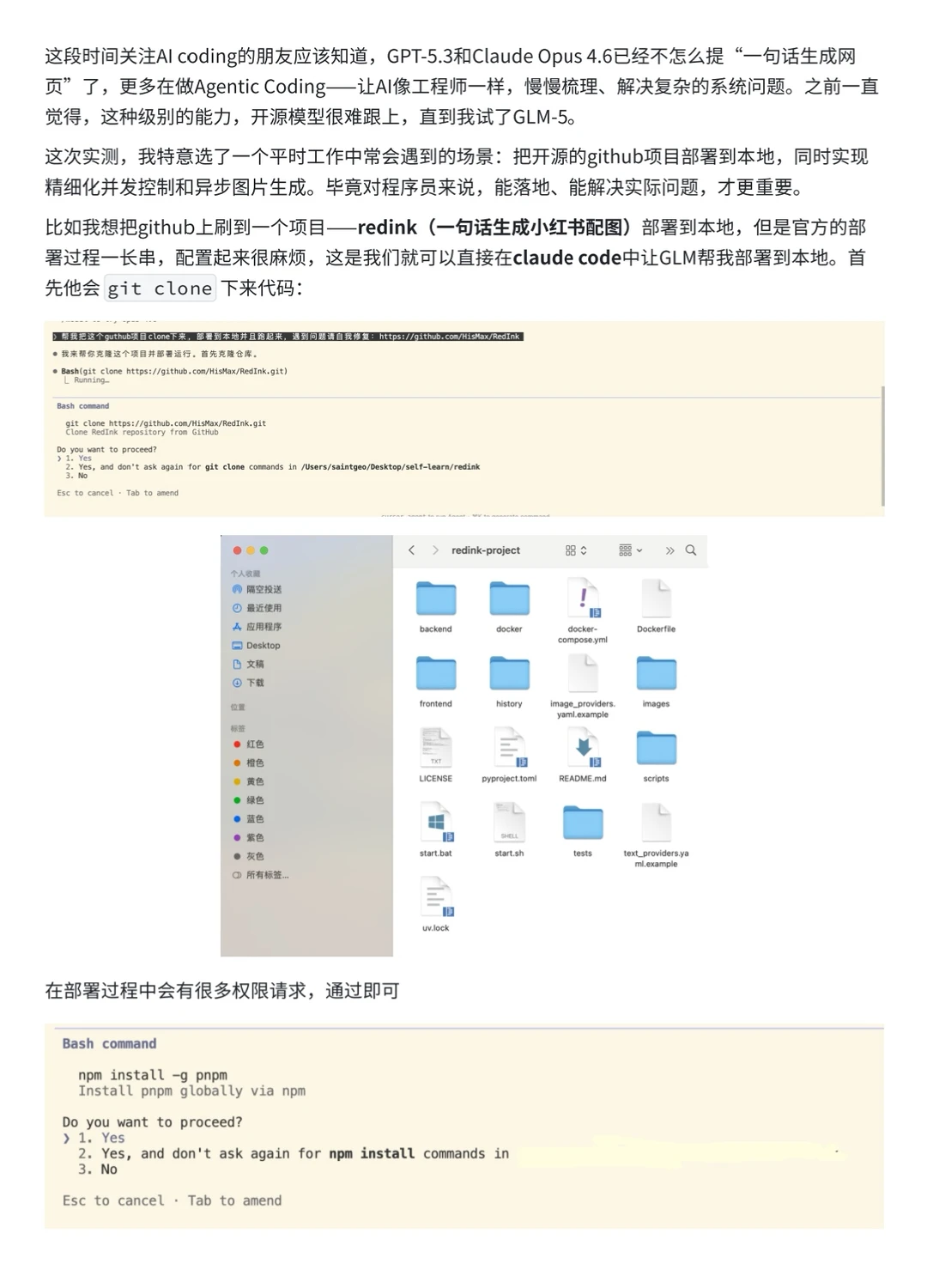

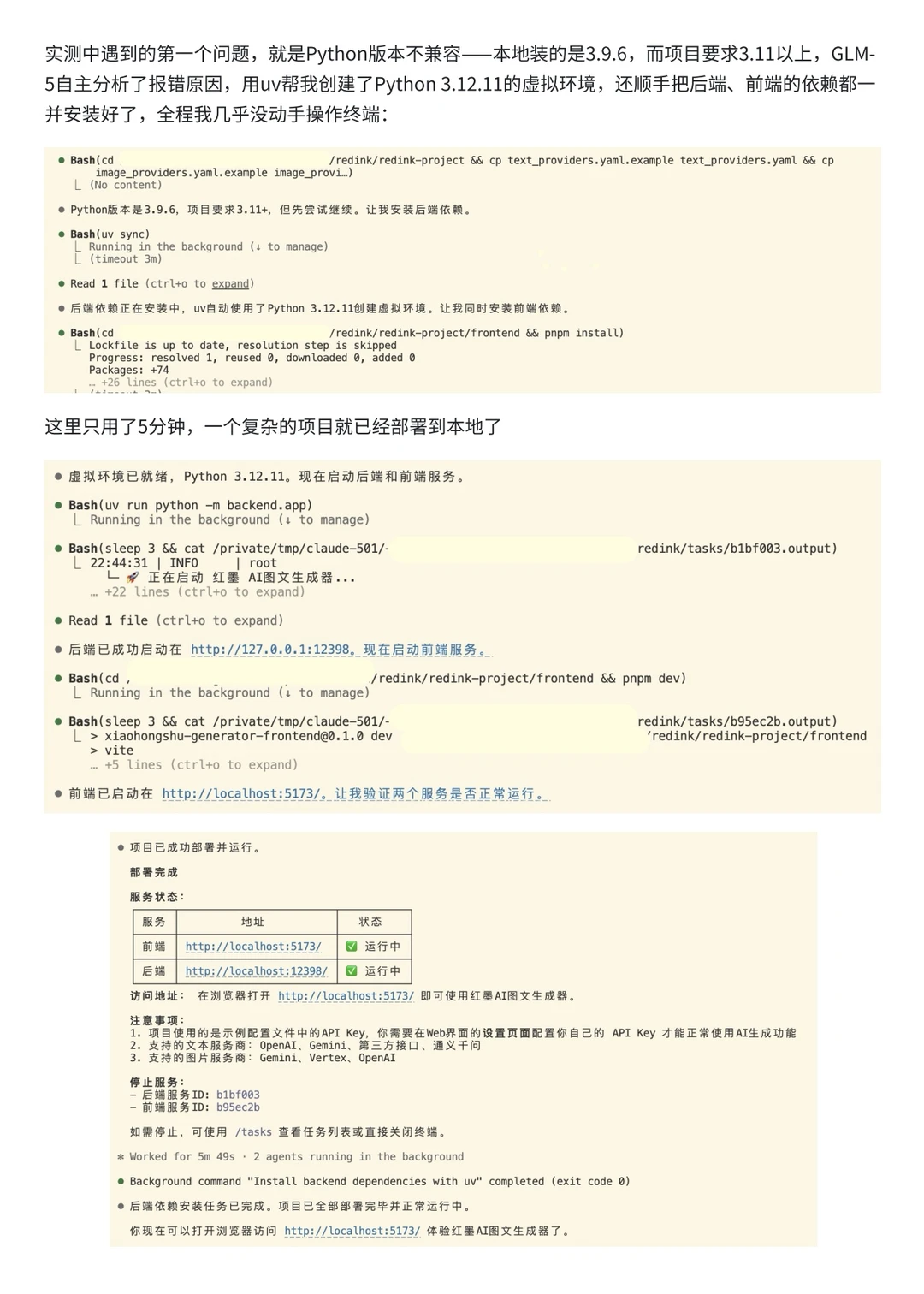

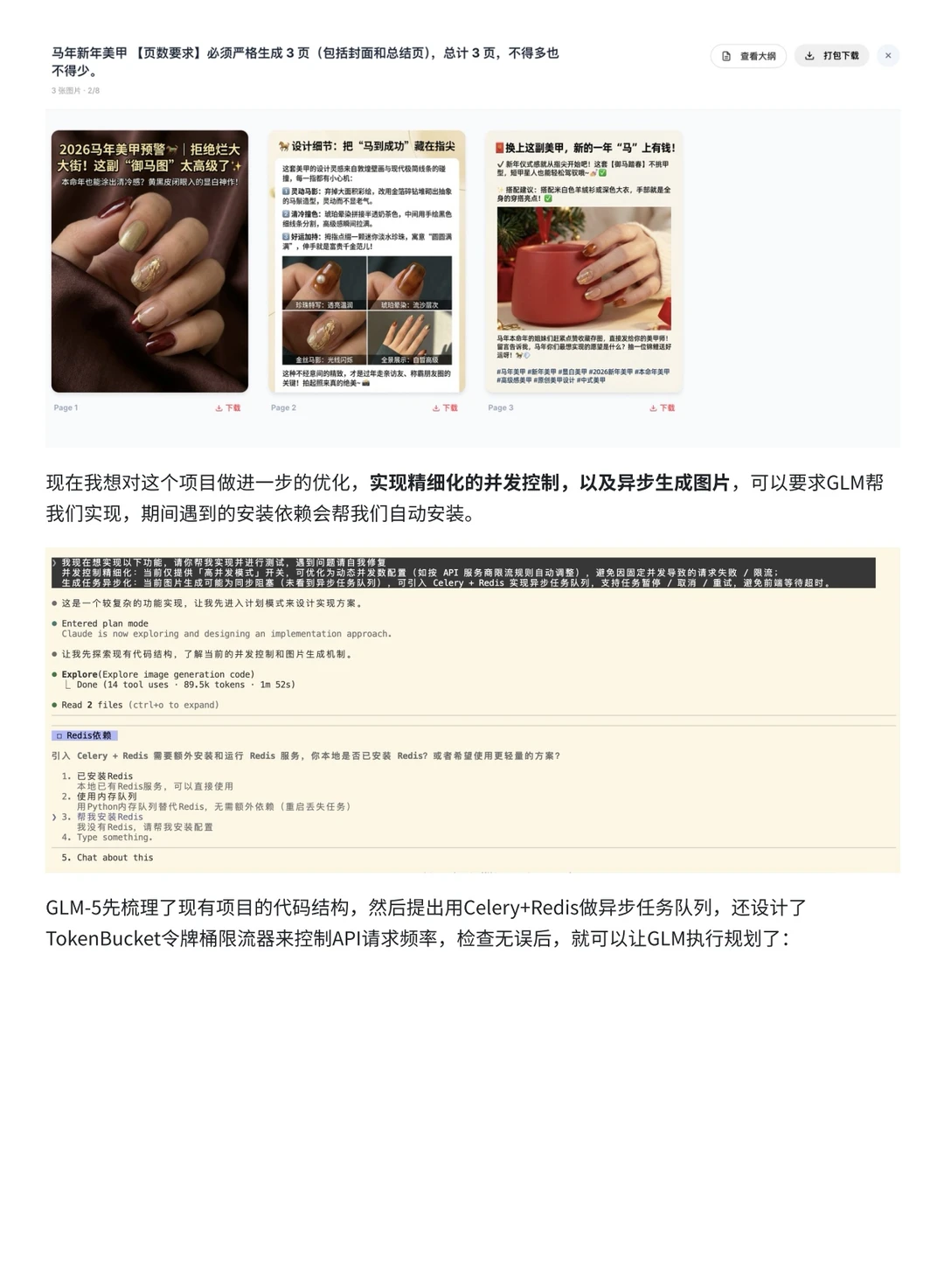

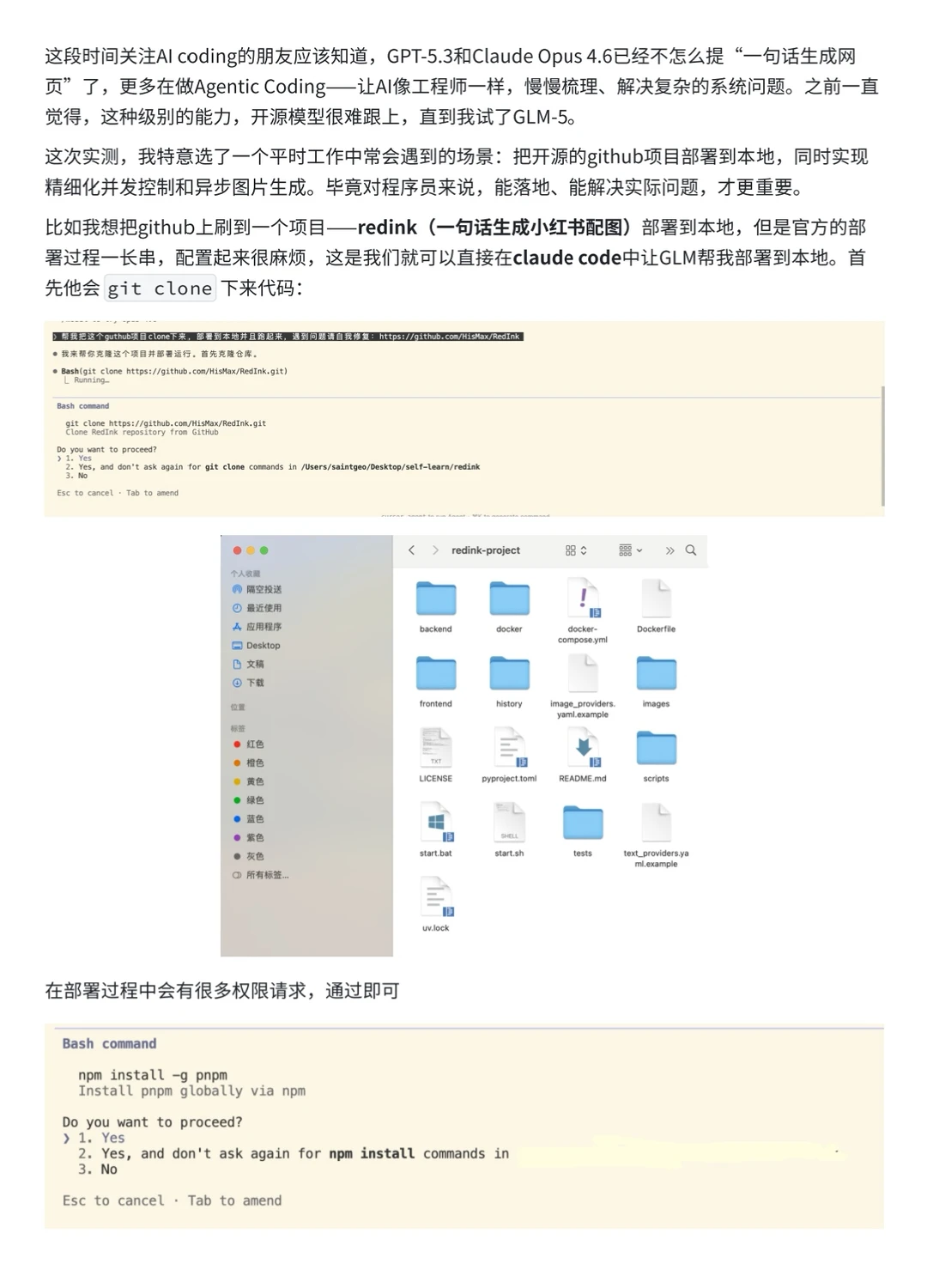

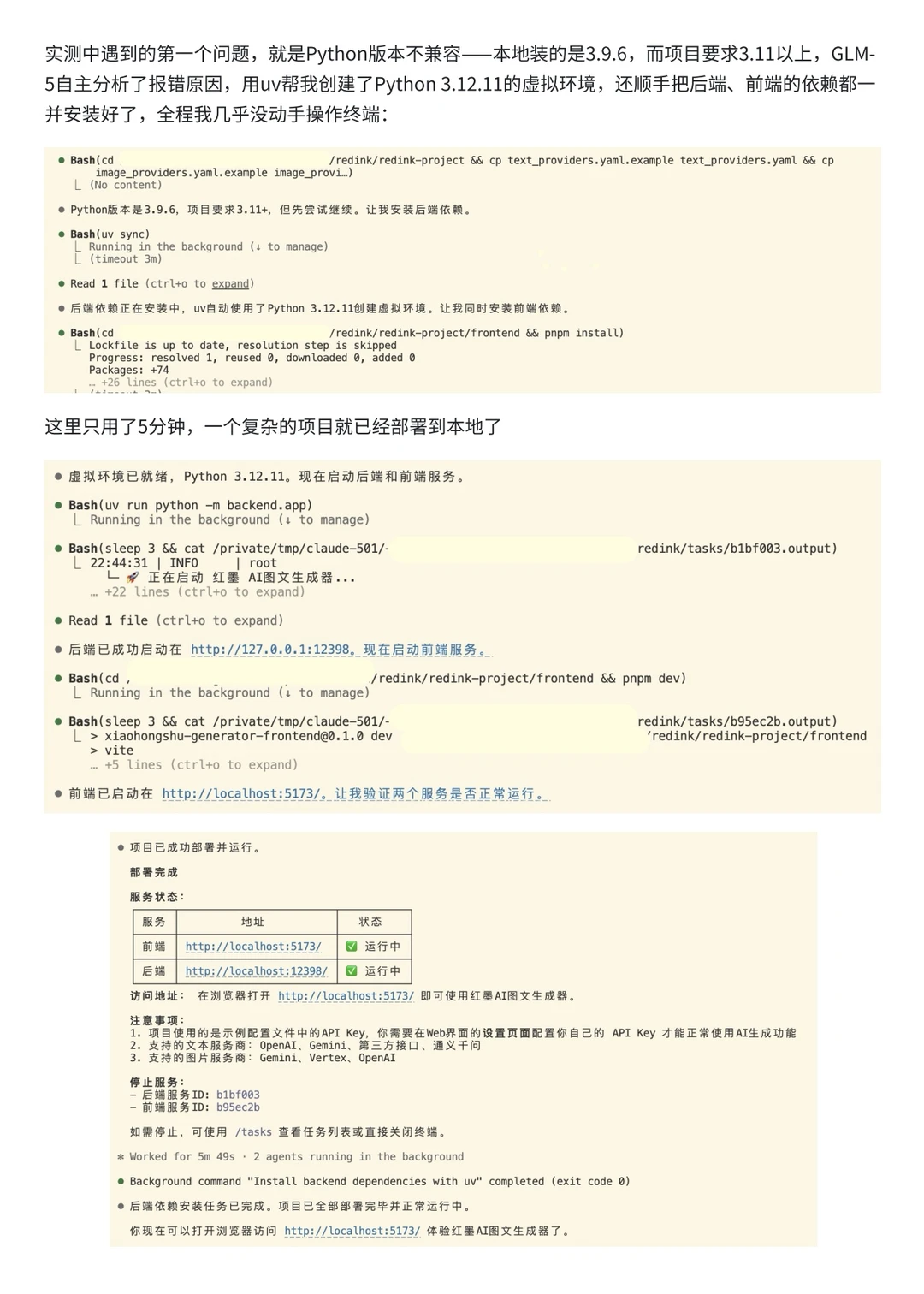

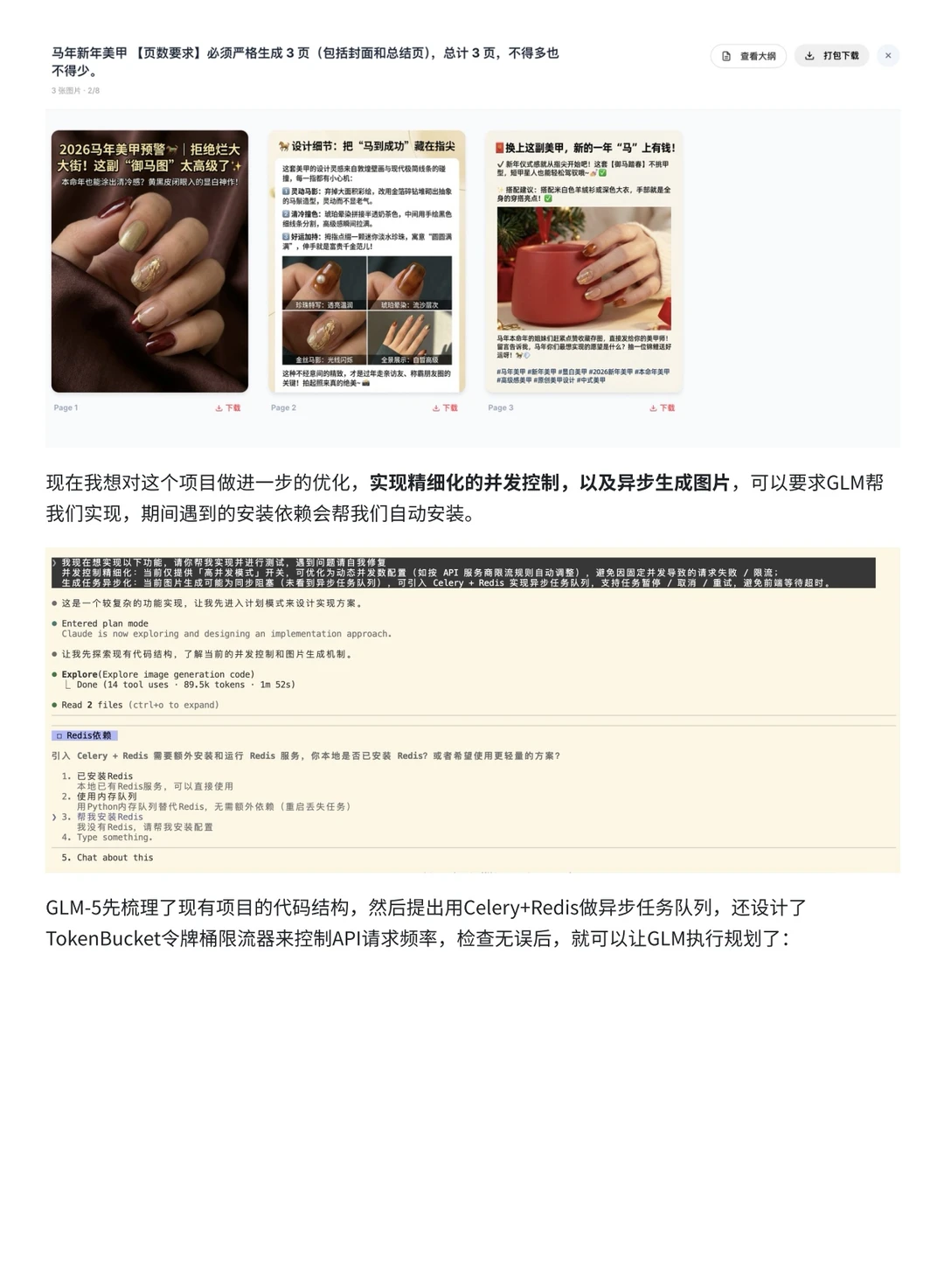

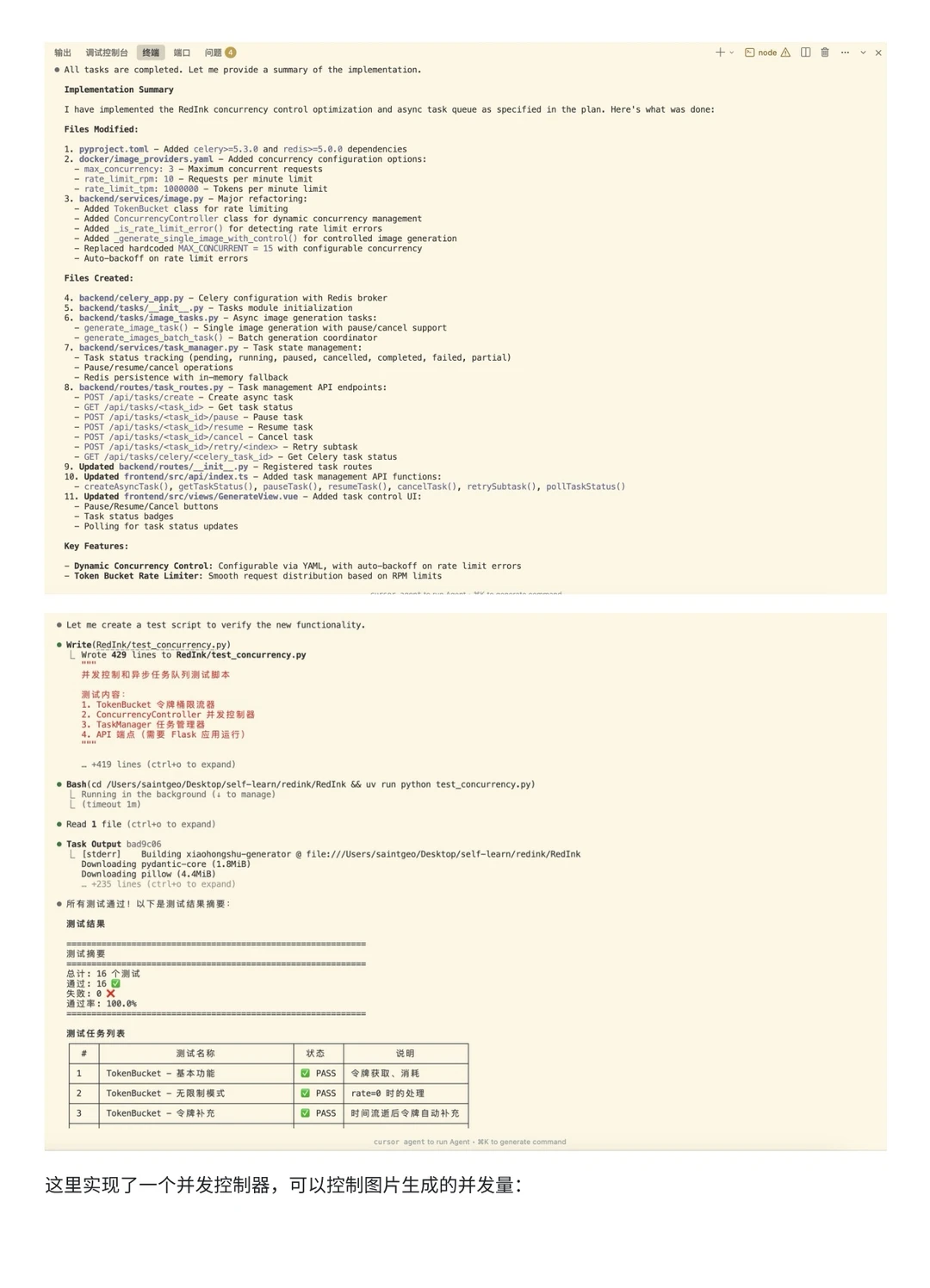

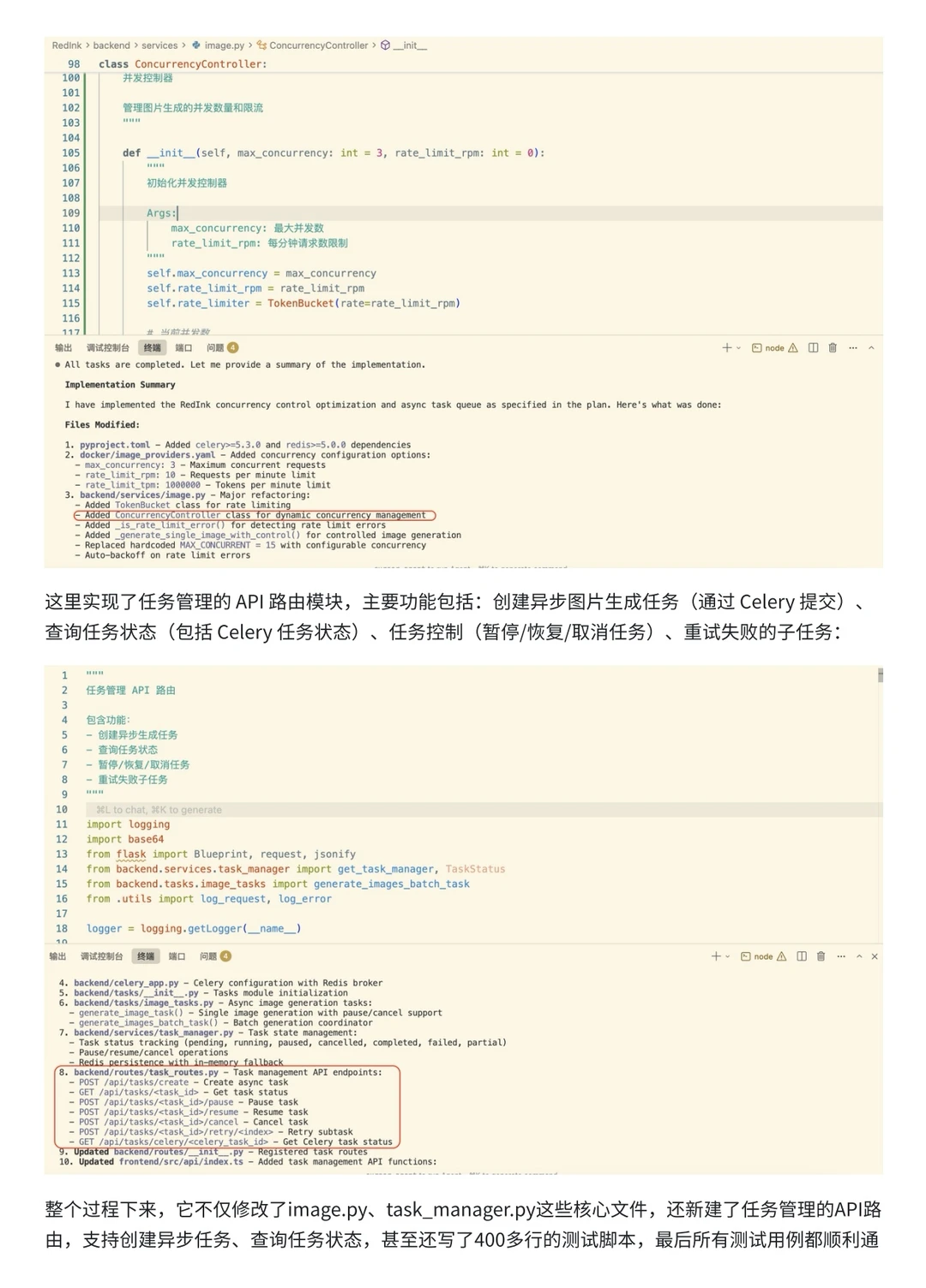

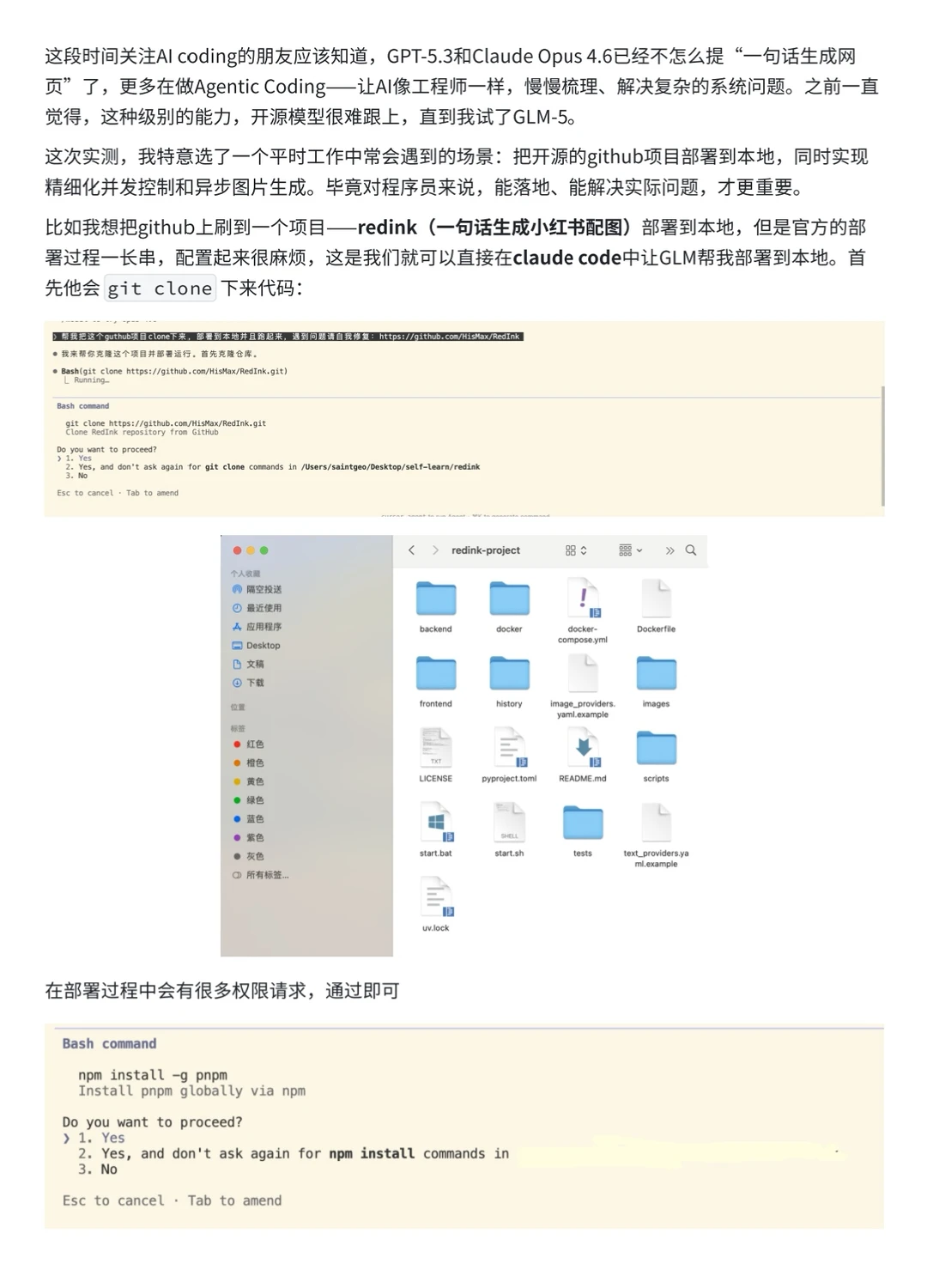

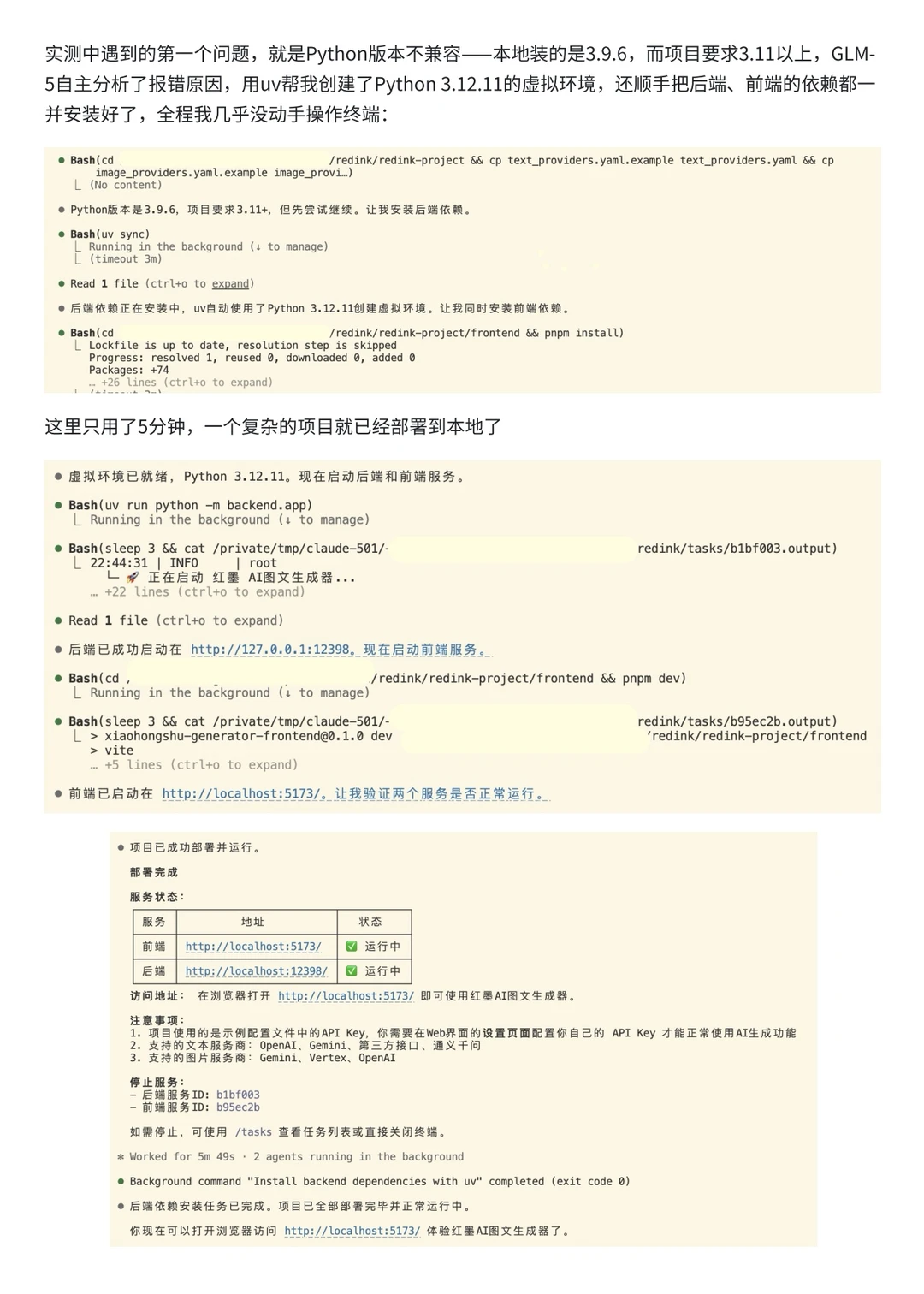

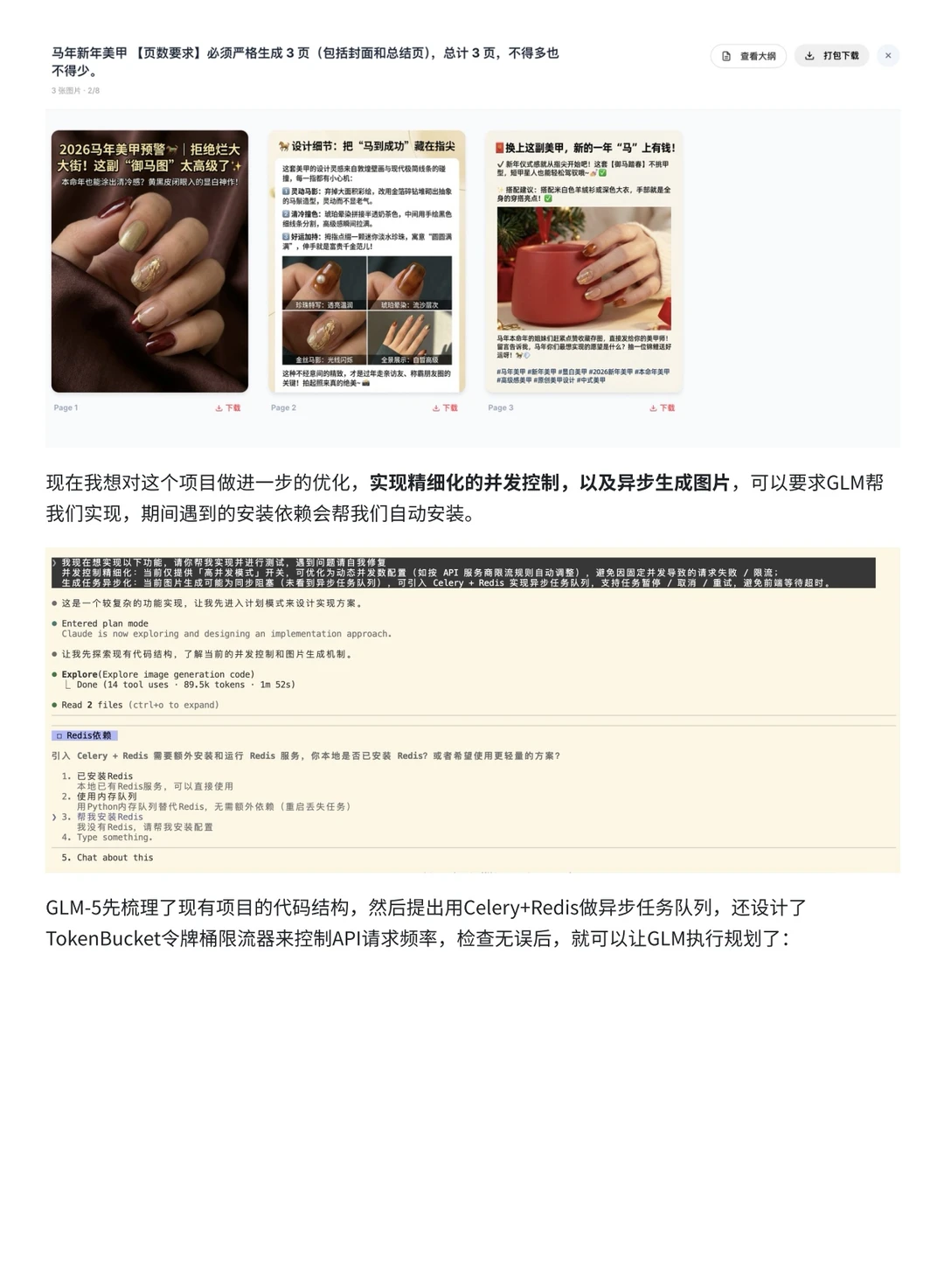

一起来测测GLM-5在复杂工程任务上的效果吧~