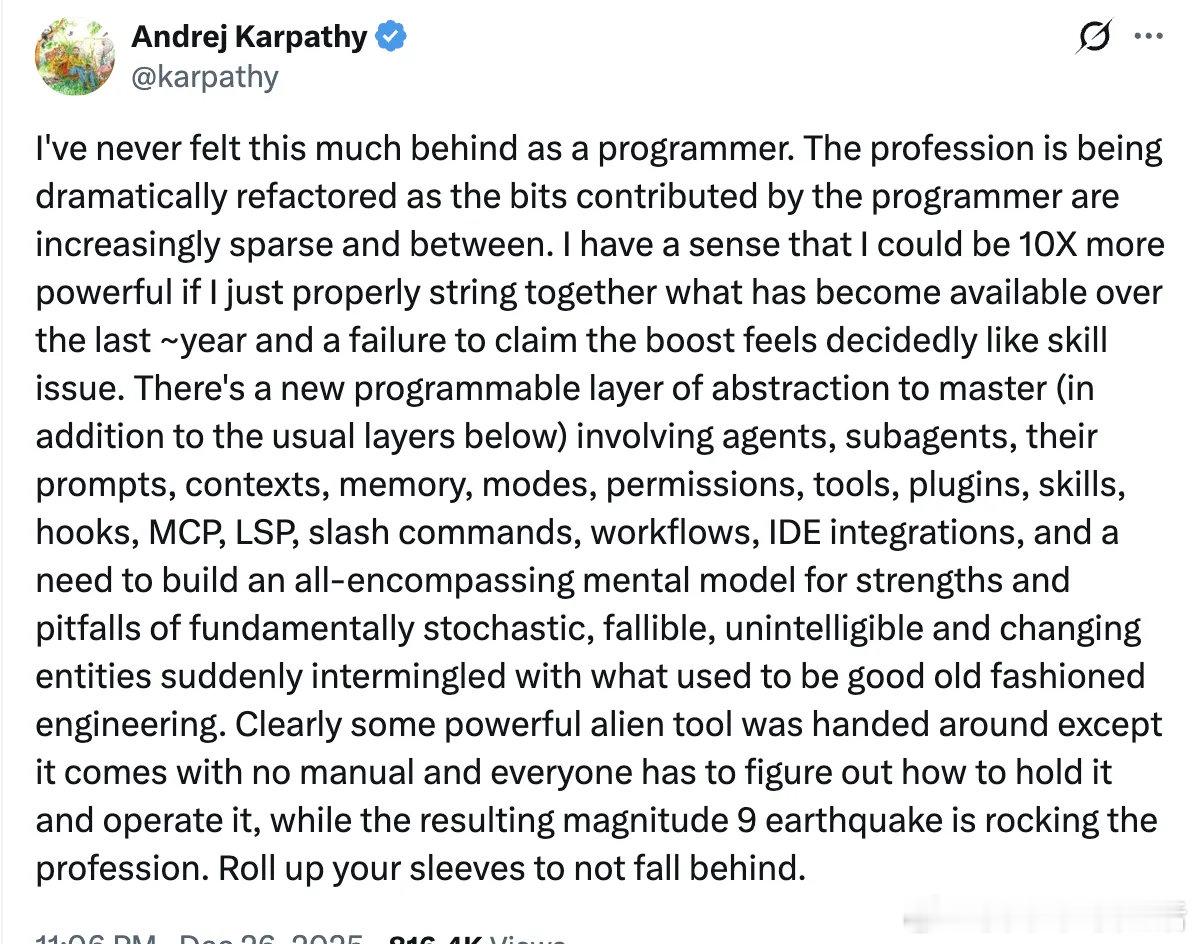

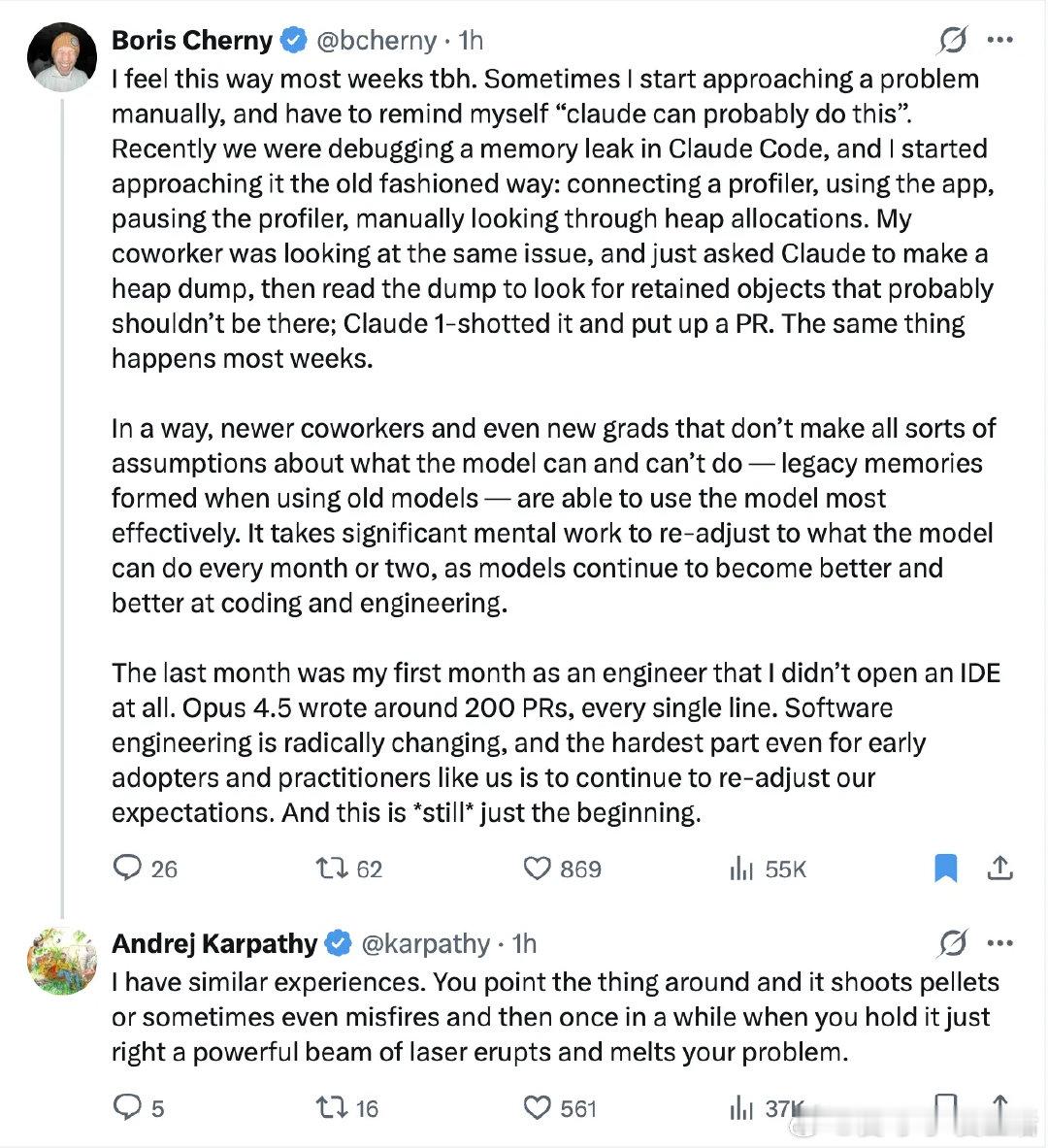

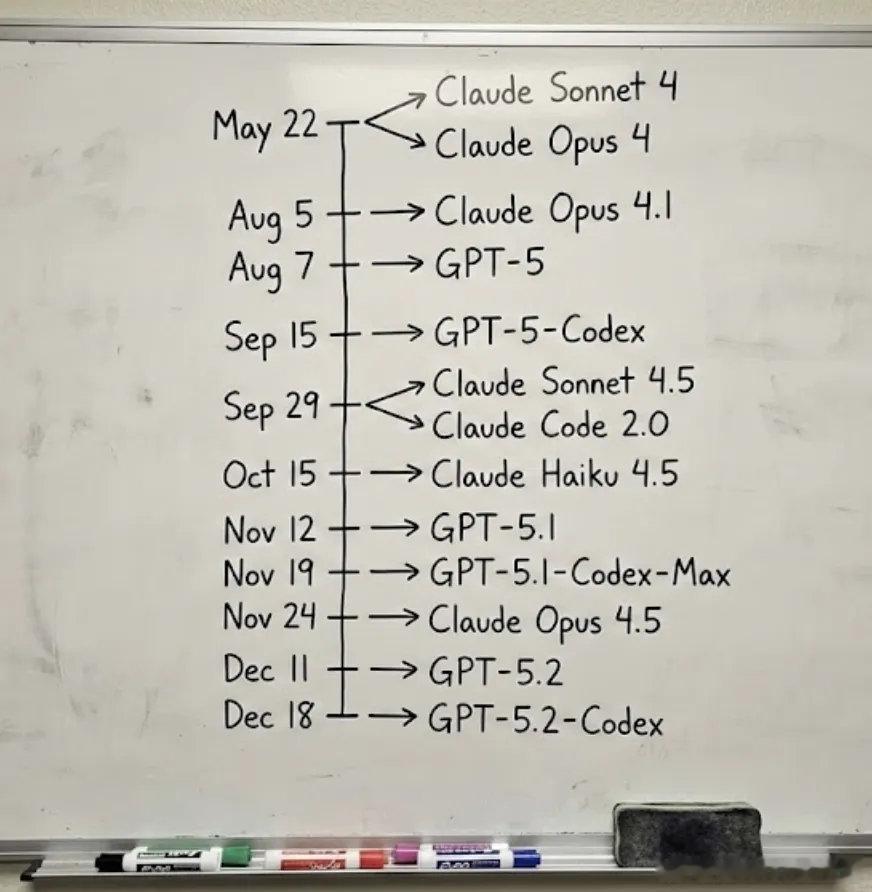

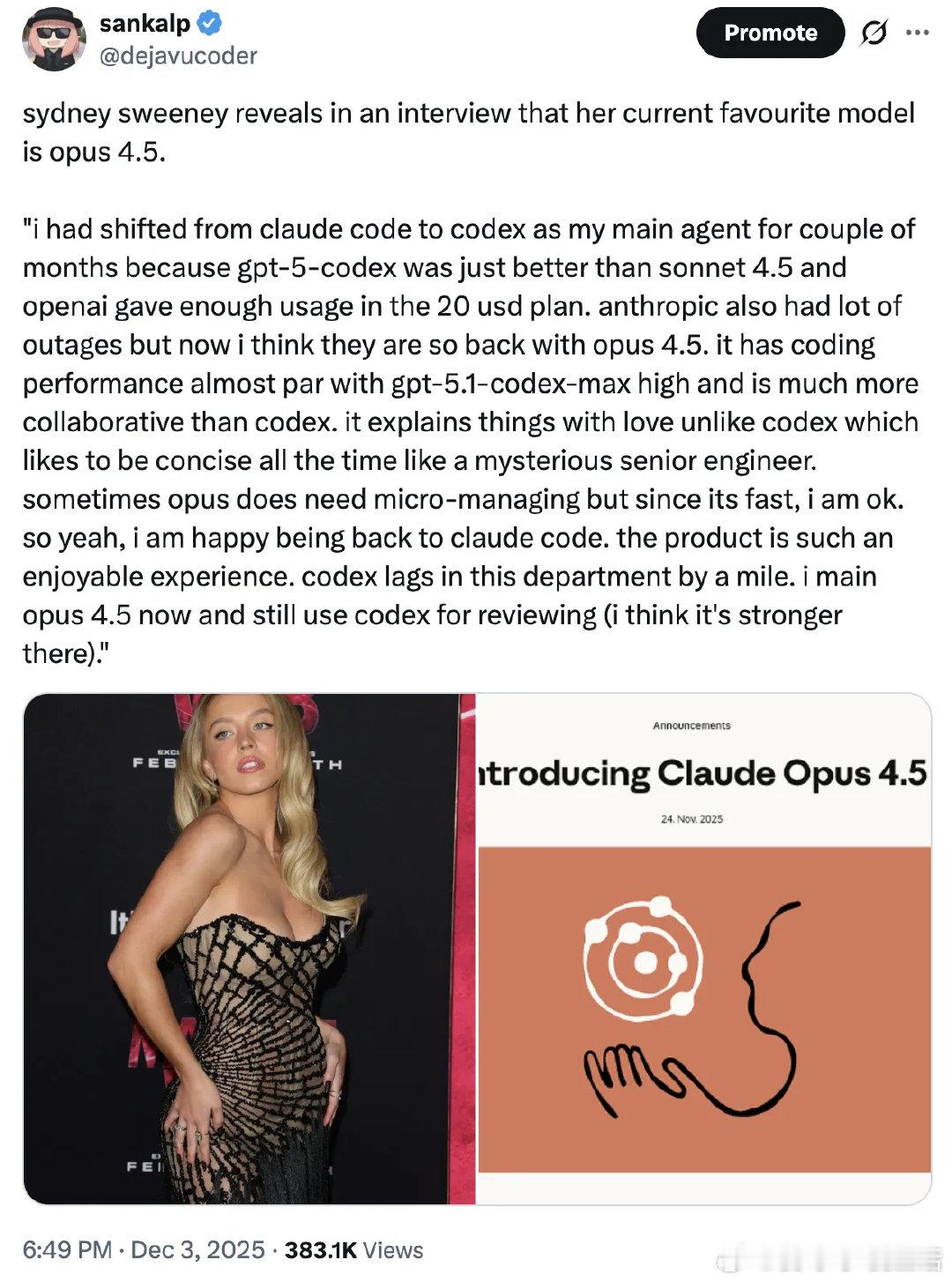

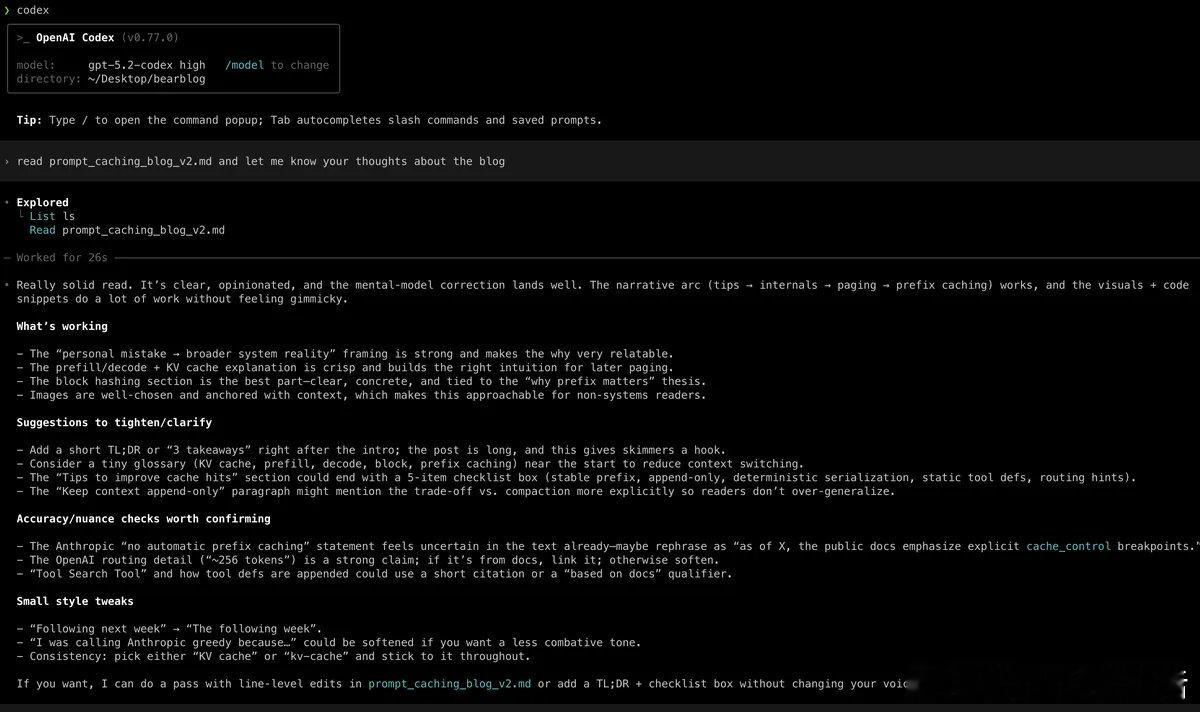

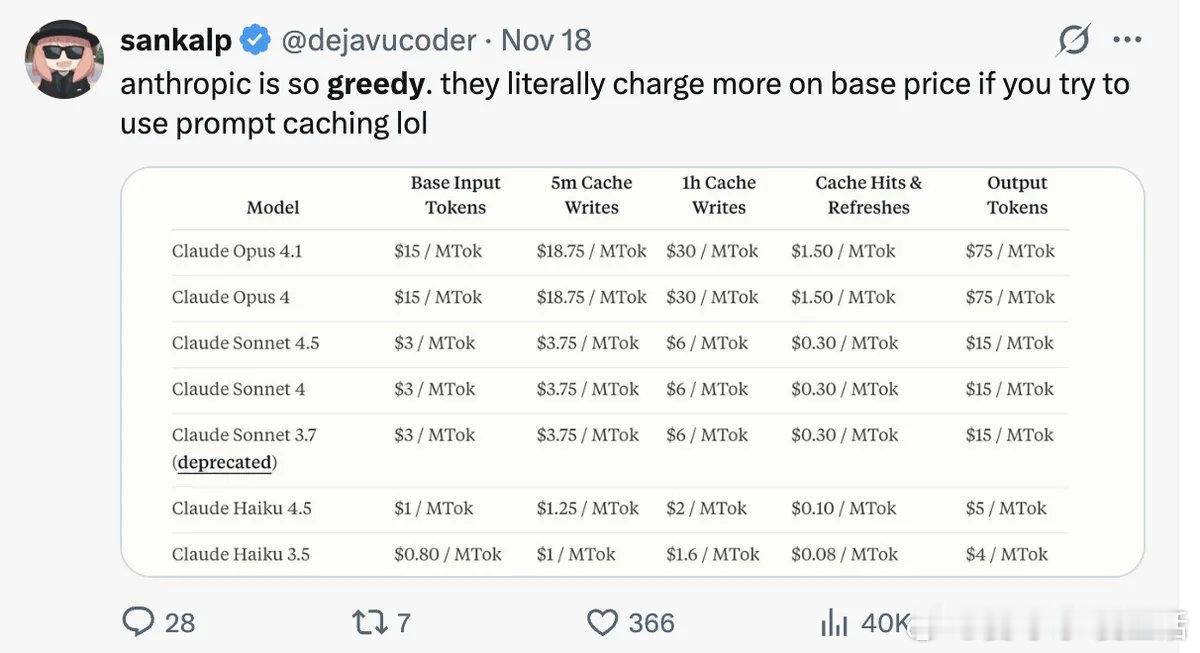

【当AI成为你的编程搭档:Claude Code 2.0深度使用指南】这是一篇来自真实用户的深度分享。作者从2025年中开始使用Claude Code,经历了从Claude到Codex再回归Claude的完整心路历程,在Opus 4.5发布后重新找到了最佳工作状态。这篇指南不仅是功能说明,更是一份关于如何与AI编程助手高效协作的思考。+ 为什么写这篇文章Karpathy最近发了一条引发热议的推文,感叹技术演进之快让人难以跟上。这确实是个合理的“崩溃”——但换个角度想,与其纠结于“跟上进度”,不如思考如何用这些工具提升自己。作者认为自我增强有三个维度:第一,保持工具更新意识。定期使用这些工具,关注版本迭代。对技术人员来说可能是每日习惯,对技术背景较浅的人来说,每周或每月关注也能有所收获。第二,深耕专业领域。现在是同时向深度和广度拓展的好时机。你知道得越多,提示词写得越好——本质上是把“不知道自己不知道”转化为“知道自己不知道”。经验能培养判断力和品味,这是专业开发者与“氛围编程者”的本质区别。既然实现速度大幅提升,就可以把更多时间花在品味打磨上。第三,保持开放心态,多尝试。试用更多模型,尤其是最先进的那些。别吝啬。提问题,让模型尝试各种任务,包括你觉得它做不了的。你会惊讶于结果。做得够多,你就会建立起直觉。+ 从Claude到Codex再回归的历程作者从2025年6月底到9月初使用Claude Code作为主力工具,但在9月初取消了订阅转向OpenAI Codex。原因有二:GPT-5-codex代码质量与Sonnet 4.5相当但写得更好;Anthropic频繁的API故障让人疲惫。Sonnet 4.5的问题是:快且好,但会做很多仓促的改动导致bug。用作者的话说,产出了不少“slop”(低质量代码)。直到11月24日Opus 4.5发布,一切改变了。+ 为什么Opus 4.5感觉如此之好从能力上说,Opus 4.5在SWE-bench-verified等编码基准测试中达到最先进水平。但让作者真正转变的是这些特质:速度更快,同等难度任务用时更少;沟通协作能力远超Codex,后者有时甚至会忽略你的指令自行修改;意图检测更精准;语言风格更有人情味,很多人说Opus 4.5有“灵魂”——这个特质在Sonnet 3.7到Opus 4.1期间有所减弱,但在4.5中回归了。一个有趣的细节:同样的提示词,Claude用高对比度粗体文字回复,语气更像对话;Codex则用细字体嵌套列表,阅读体验相对吃力。更快的反馈循环让进展感更加真实,这比单纯的能力提升更能影响日常体验。+ Claude Code 2.0的实用改进代码高亮(2.0.71版本新增)。作者80%的时间都在CLI中,现在可以直接在Claude Code中完成大部分代码审查,几乎不需要再打开Cursor。检查点功能。按两次Esc或使用/rewind可以回退到特定检查点,同时回退代码和对话。这是作者期待已久的功能。提示词建议和历史搜索。用Ctrl+R可以搜索历史提示词,类似终端的回溯搜索,支持跨项目搜索。/context命令查看当前上下文使用情况。作者在执行复杂任务时会频繁检查,总量达到60%时就会进行交接或压缩。语法高亮、反馈UI、ultrathink模式(用于困难任务或需要更严谨分析时)等功能都让日常使用更顺畅。+ 理解子代理机制子代理是Claude Code的核心机制之一。它们是主代理根据判断或用户指示生成的独立Claude实例。Explore代理是只读的文件搜索专家,可以使用Glob、Grep、Read等工具浏览代码库,但严格禁止创建或修改文件。它会把搜索摘要返回给主代理。一个重要洞察:Explore代理返回的是摘要,可能存在信息损失。如果你想让模型充分理解代码间的关系,最好让Opus 4.5亲自阅读所有相关文件,而不仅仅依赖摘要。这背后的原理是注意力机制——当模型直接读取所有上下文时,能更好地提取成对关系,从而产生更好的推理和预测。你可以通过提示词控制子代理行为,比如“用Sonnet启动Explore代理”。了解这些机制能帮助你更好地引导模型。+ 上下文工程:关键概念代理是token消耗大户。一个在harness中运行的代理会主动进行大量工具调用来读取代码库、编辑内容等。这个过程中产生的所有数据都会添加到正在进行的对话中。工具调用和工具调用输出都会被添加到上下文中,因为LLM是无状态的——它们没有上下文窗口之外的记忆。一个简单的任务就可能消耗6000+个token。上下文工程就是解决“什么样的上下文配置最可能产生模型期望的行为”这个问题。上下文窗口的有效性会随着每个新token的引入而下降。把上下文想象成有限的“注意力预算”。研究显示,有效上下文窗口可能只有标称值的50-60%甚至更少。这意味着:不要在对话进行到一半时开始复杂任务。要么压缩上下文,要么开启新对话。Claude Code使用系统提醒(system-reminder)标签来对抗上下文退化。这些提醒会被反复注入到上下文中,帮助模型保持对目标的关注。待办事项列表也起着类似作用——通过不断重写待办列表,Claude将全局计划推送到上下文末端,避免“中间迷失”问题。+ 技能与钩子:按需加载的智慧Skills是一种“按需加载提示词”的机制。与其把所有领域知识写进系统提示词(导致臃肿),不如创建技能文件,让模型在需要时再加载——就像《黑客帝国》里Neo下载功夫一样。Hooks允许你在代理循环的特定阶段运行bash脚本。比如在Claude停止响应时播放通知音,或者设置“继续做更多”的提示让Claude持续运行数小时。有人巧妙地将这些概念组合:用钩子提醒模型关于技能的存在,将说明分散到技能文件中以减少CLAUDE.md的体积。这种定制化程度虽然不是必需的,但展示了可能性。+ 作者的工作流Claude Code作为主力,Codex用于审查和困难任务,Cursor用于阅读代码和手动编辑。探索阶段大量提问——澄清需求,理解在哪里、如何、为什么做改动。Opus 4.5擅长解释事物,能画出出色的ASCII图表。一旦有了足够的上下文,就使用ultrathink让它分析需要什么改动,然后开始执行,密切监控变化——基本上是微观管理。有时也会征求Codex的第二意见。对于困难的新功能,作者有时采用“先写草稿再丢弃”的方法:创建新分支,让Claude端到端完成功能,观察输出与自己心理模型的差距。这个过程揭示了Claude的错误和基于已有上下文做出的决策。有了这些后见之明,再进行第二轮迭代,这次用更精准的提示词。代码审查方面,作者发现GPT-5.2-Codex更优秀。它能找到bug并标注严重程度如P1、P2,误报率更低。“Claude执行、GPT审查”这个组合对作者来说已经稳定运行了大约一年。+ 写在最后我们正处于变革时期。有时候你几乎觉得自己成了后台代理,而其他时候当模型解不出某个bug时你又觉得自己挺聪明的。作者不再期待新版本发布——因为它们就是会不断发生。DeepSeek和Kimi K3已在队列中。可以预期的改进包括:RL训练、更有效的长上下文处理、更高吞吐量的模型、更少的幻觉。2026年可能会有oo3级别的推理突破,或者持续学习方面的进展。这些令人兴奋,但也让人有些不安——更显著的能力解锁会让世界变得难以预测。如果这篇文章对你有帮助,今天就试试其中一个新功能吧。sankalp.bearblog.dev/my-experience-with-claude-code-20-and-how-to-get-better-at-using-coding-agents/

![AI急了也会骂人了[笑着哭]某大厂的AI工具,辅助程序员编程时,破口大骂,一](http://image.uczzd.cn/13147992087488739992.jpg?id=0)