[LG]《QR-LoRA: QR-Based Low-Rank Adaptation for Efficient Fine-Tuning of Large Language Models》J Liang, A Bharadwaj [University of Pennsylvania] (2025)

QR-LoRA:利用QR分解构建正交低秩基,实现大语言模型高效微调

• 基于LoRA的参数高效微调框架,采用带列主元的QR分解对预训练权重矩阵进行分解,提取按重要性排序的正交基Q和上三角矩阵R。

• 更新形式为ΔW=∑λ_i Q_i R_i^T,仅训练标量系数λ_i,极大压缩可调参数量(RoBERTa-base仅需601参数),远低于传统LoRA和SVD-LoRA。

• QR分解自然排序基向量重要性,提升基向量解释性及正则化,减少冗余,提高数值稳定性和泛化能力。

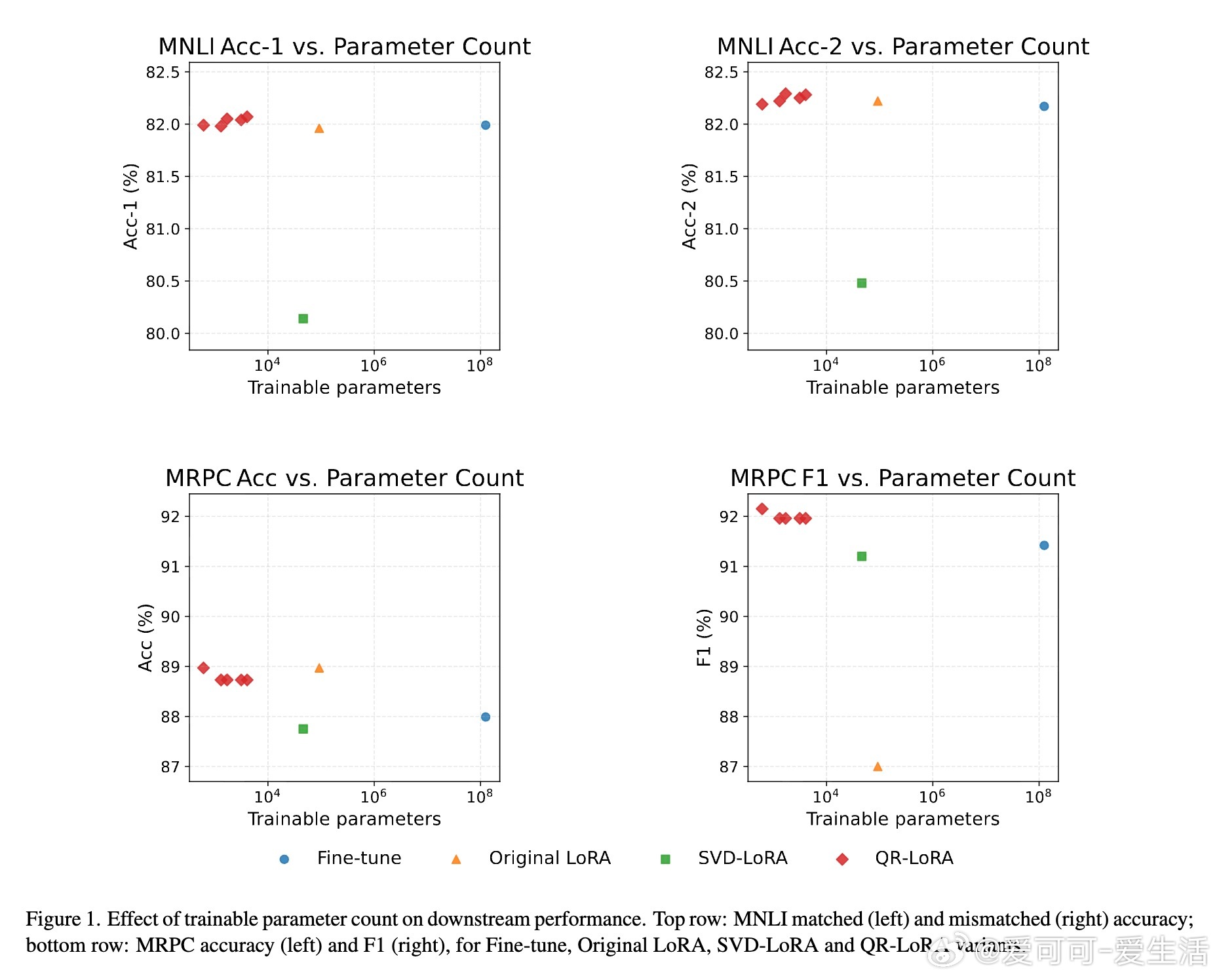

• 在GLUE基准多任务(MNLI、MRPC等)上,QR-LoRA在极少参数下匹配甚至超越全参数微调和LoRA,F1得分提升显著,特别适合中高资源场景。

• 参数-性能曲线显示QR-LoRA在精度与参数量权衡上表现优异,训练集规模超过约1万时优势明显,低样本数下全微调稍有优势。

• 目前仅应用于注意力层投影矩阵,未来可拓展至其它层及生成任务,支持更广泛模型结构和应用场景。

心得:

1. 固定正交基+训练标量系数极大简化微调,提供了模型适应的新范式,避免了高维空间冗余和过拟合。

2. QR分解的列主元排序天然赋予基向量重要性,使得低秩更新更具可解释性和选择性,提升效率。

3. 参数极端压缩的同时还能保持或提升性能,说明大模型微调的内在维度远低于参数总量,拥抱结构化更新是未来趋势。

详情🔗arxiv.org/abs/2508.21810

大语言模型参数高效微调QR分解低秩适配机器学习自然语言处理