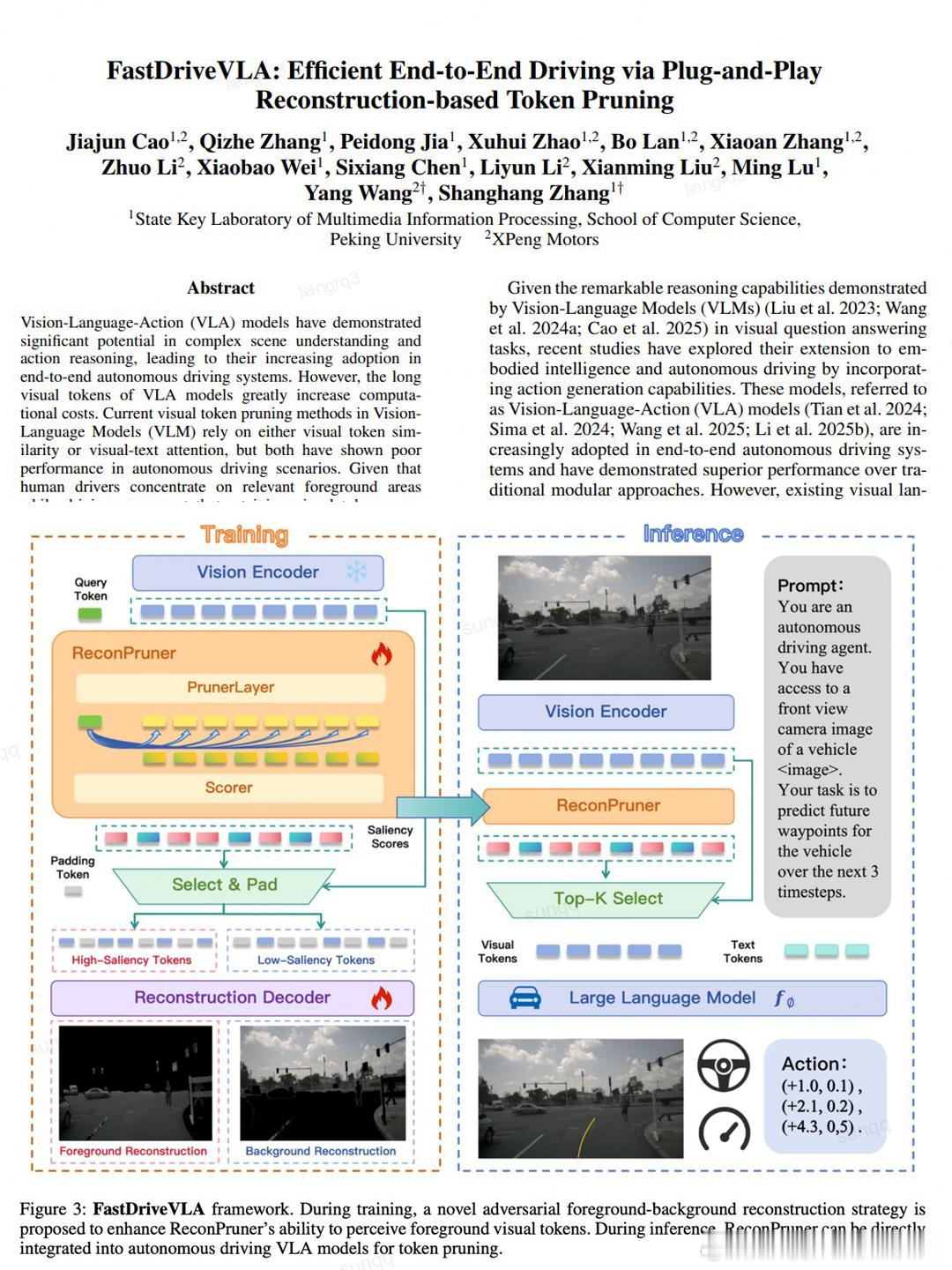

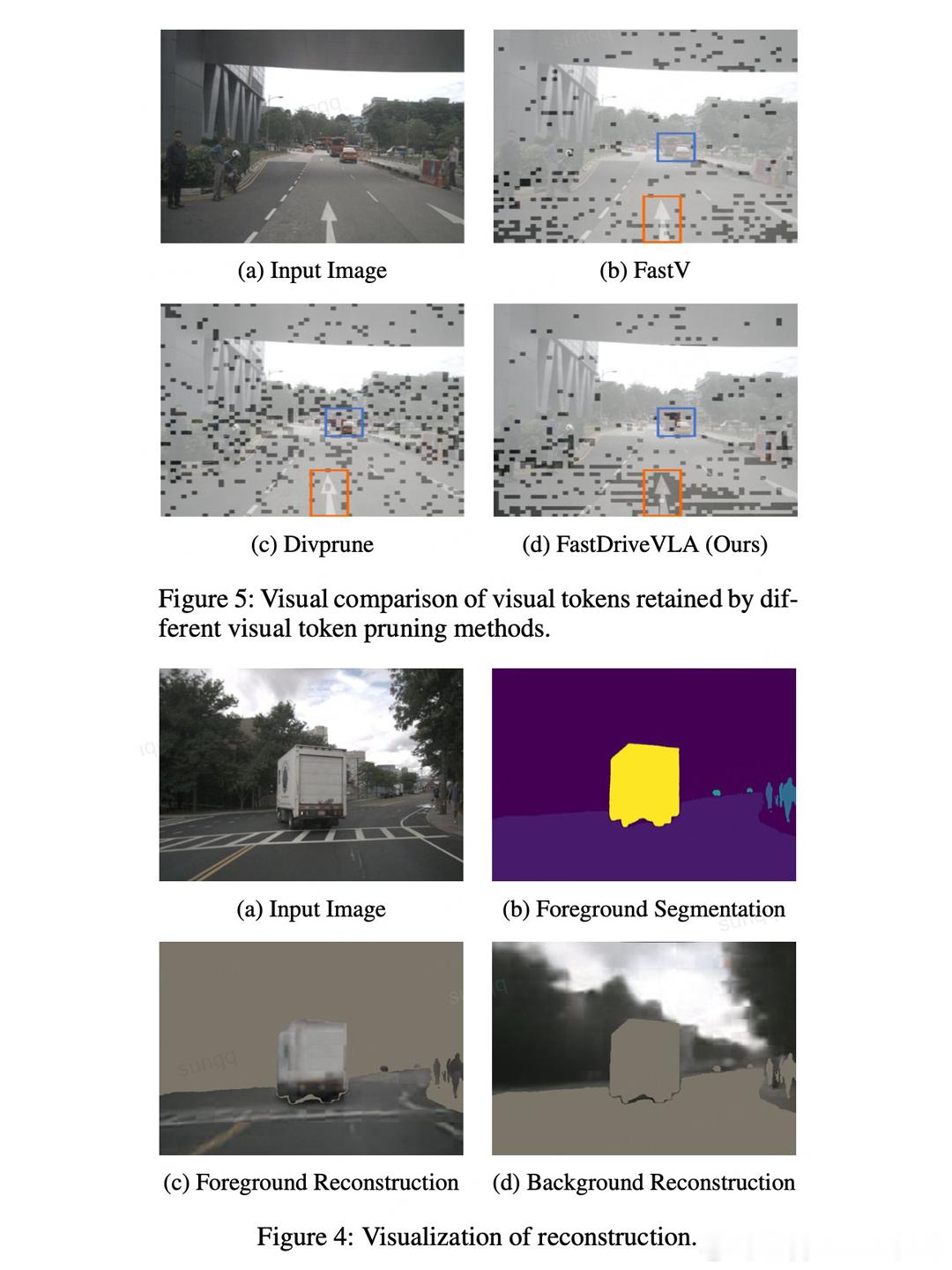

近期自动驾驶圈有个重磅消息,小鹏汽车和北京大学联合研发的成果,成功登上了人工智能顶会AAAI 2026。这次他们搞出的“视觉令牌剪枝(Visual Token Pruning)”框架,看似专业,实则解决了高阶智驾落地的核心痛点,让L4级自动驾驶离我们又近了一大步。先搞懂一个关键问题,为什么非要花大力气做这项技术?现在主流的VLA 2.0智驾模型,本事不小,能直接处理摄像头拍的视觉画面,不用复杂的信号转译,就能直接生成驾驶动作指令,相当于给车装了“直接看路决策”的能力。但问题也很致命:它处理图像时,会把眼前的场景拆成海量“视觉令牌”,就像把一张照片切成几千个小碎片逐个分析。这会让车载电脑不堪重负,计算速度变慢,实时决策跟不上,哪怕技术再先进,也没法真正装到车上用。简单说,不解决这个“算力包袱”,高阶智驾就是纸上谈兵。而小鹏和北大联合研发的FastDriveVLA框架,就是专门给智驾模型“减负”的神器,核心优势藏在“选择性观察”这五个字里。团队从人类开车的习惯里找了灵感,我们开车时只会重点看车辆、行人、红绿灯这些关键信息,不会盯着天空、远处的静止建筑发呆。而这项技术就是让模型学会这种“取舍”。通过专属的视觉令牌剪枝(Visual Token Pruning)框架,精准剔除那些没用的冗余视觉令牌,只保留和驾驶决策相关的关键信息。不用重新训练主模型,就能直接适配现有VLA系统,相当于“即插即用”,落地成本大大降低。更关键的亮点的是,它实现了“效率和精度的双赢”。以往有些技术想降低计算量,难免会牺牲决策准确性,但FastDriveVLA能在把计算量减少7.5倍、推理速度提升3倍多的同时,核心驾驶指标还优于未剪枝的模型。这种“减负不降级”的能力,正是行业里稀缺的关键突破。另外提一句,理想汽车也在做同款 VLA 智驾技术,自研了 MindVLA 框架,核心也是想让智驾模型更高效、更好上车,只是技术路子不一样。理想靠 MoE 混合架构、稀疏注意力等方式轻量化模型,暂时没用到小鹏这种「视觉令牌剪枝」的方法,算是同目标、不同解法。总之,小鹏这次成果被AAAI 2026收录,也意味着这项技术得到了国际学术界的权威认可。对用户来说,这背后是L4级自动驾驶规模化落地的加速,未来能享受到更安全、更流畅的智能驾驶体验。大v聊车