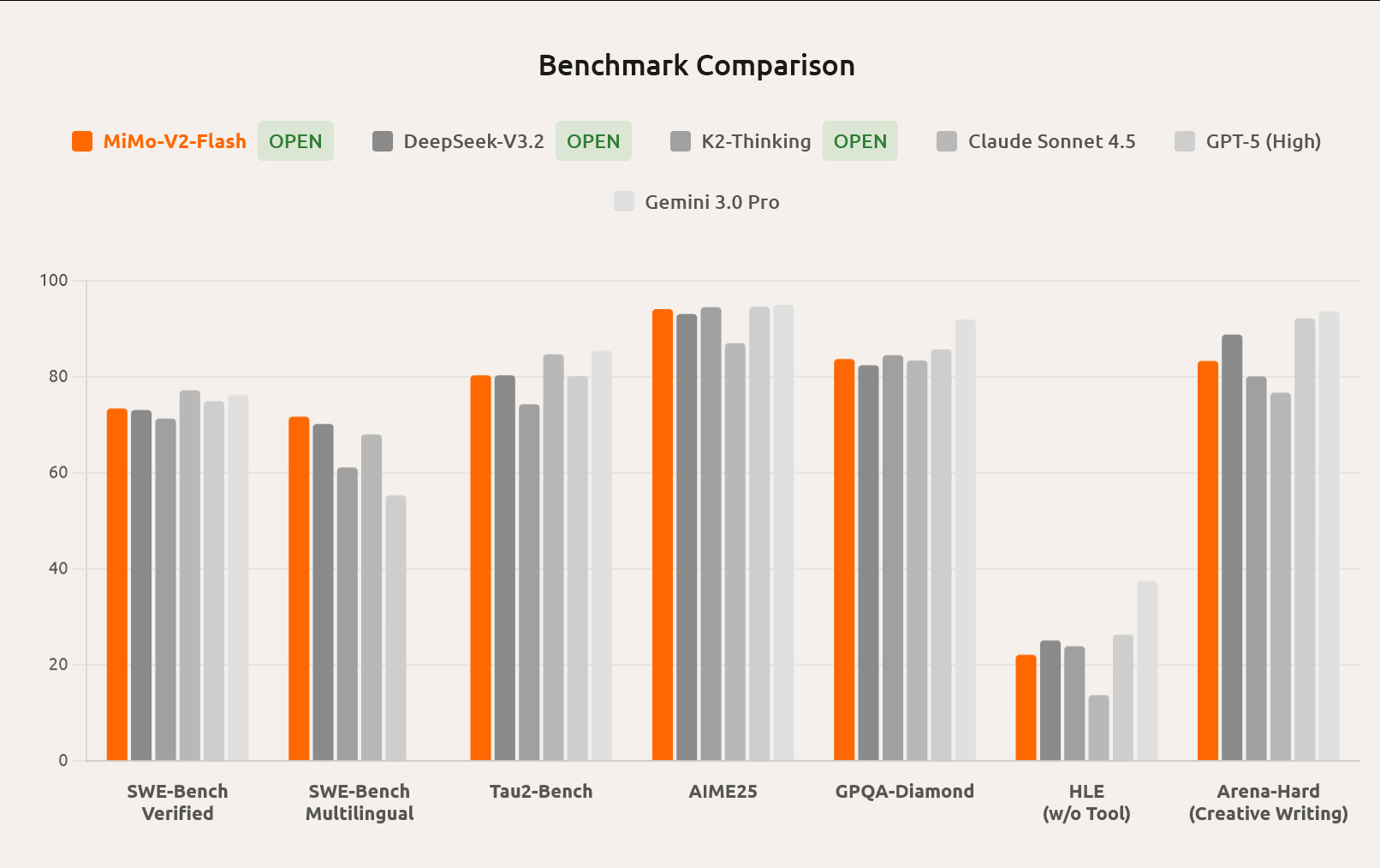

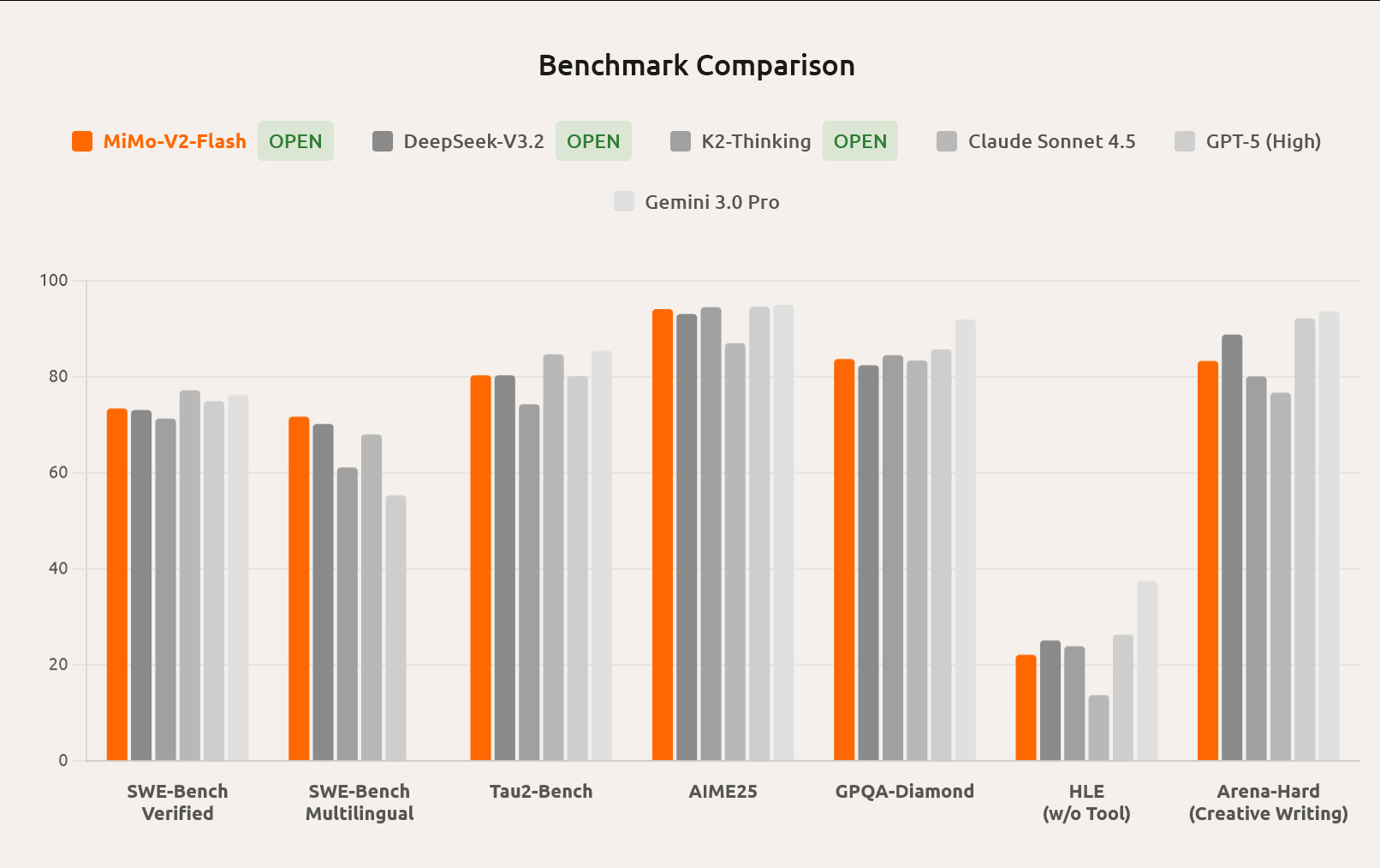

罗福莉加入小米后发布的第一个大模型来啦。 MiMo-V2-Flash,开源MoE模型,总参数309B,激活15B。采用交错的“滑动窗口注意力”(SWA)与“全局注意力”(Global Attention)架构。罗福莉在技术报告里是通讯作者,应该是起了主导作用。技术报告: github.com/XiaomiMiMo/MiMo-V2-Flash/跑分在同参数里算不错的。再等等实测看看效果。科技先锋官AI创造营

罗福莉加入小米后发布的第一个大模型来啦。 MiMo-V2-Flash,开源MoE模型,总参数309B,激活15B。采用交错的“滑动窗口注意力”(SWA)与“全局注意力”(Global Attention)架构。罗福莉在技术报告里是通讯作者,应该是起了主导作用。技术报告: github.com/XiaomiMiMo/MiMo-V2-Flash/跑分在同参数里算不错的。再等等实测看看效果。科技先锋官AI创造营

作者最新文章

热门分类

科技TOP

科技最新文章